[[initdata(8,0,3)]]

Ollama

LightTools

2024-05-22

ollama是个可以一键运行本地大语言模型的开源平台,可以快速在本地搭建运行开源大语言模型 - 多平台支持 Linux,Windows,MacOS都可以轻松安装 - 一键运行,仅需要一条命令,ollama便可下载运行大语言模型

详细介绍

ollama下载链接: https://ollama.com/download

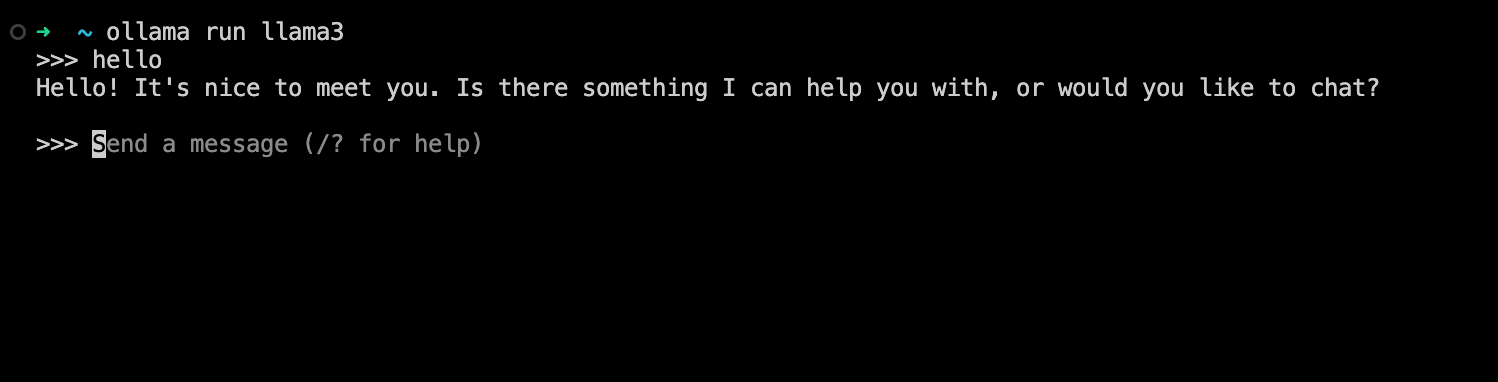

安装好ollama后仅需要执行 ollama run llama3 即可运行Meta最新发布的llama3模型,直接就可以在命令行中跟本地大模型对话,非常方便

- 首次运行需要下载模型文件llama3默认是8b版本,大小是4.7G

- 运行8b版本大概是需要占用4~5GB内存

- ollama会优先使用显卡,实测1080显卡也能有流畅的输出,没有显卡也会使用CPU来运行,不过速度就很慢

- llama3 70b版本就需要比较高的配置才能运行,推荐64G内存+24G显存

- 支持的模型列表 https://ollama.com/library

- 支持以服务的方式在后台运行:

ollama serve - 支持API方式调用,默认端口是:11434

curl http://localhost:11434/api/chat -d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'- 常用参数,需要以环境变量方式设置

#设置服务监听的主机地址,支持局域网访问

OLLAMA_HOST=0.0.0.0

#同一个模型的最大并发处理数

OLLAMA_NUM_PARALLEL=4

#模型加载数量,设置为2则表示运行2个模型同时运行

OLLAMA_MAX_LOADED_MODELS=2相关链接

AI

开源

[[list[8]?.like_count]]

0

共[[list[8]?.comment_count]]条评论

[[v.content]]

[[v2.content]]