infinifi

infinifi,一个循环播放舒缓的背景音乐的网站 - 背景音乐由大模型生成 - 界面简洁,仅一个播放按钮

使用链接

界面

特点

- infinifi 的工作原理是使用 Meta 的MusicGen模型在后台连续生成 5 个 1 分钟的 lofi 音乐片段。每个片段都使用略有不同的提示生成,以提供具有不同但仍然舒适的氛围的音乐片段

其它链接

AI灵感PPT

在线一键PPT生成工具,万字文档总结生成PPT,支持AI思维导图制作、AI绘图、AI配音、AI写作等常用功能

应用平台

Windows 、 MacOS

官方网站

应用简介

一、支持2种智能PPT生成模式

1.1 一句话生成PPT AI灵感PPT 支持根据指定主题生成PPT内容;可自由控制PPT页数;上百款PPT模板自由选择;主题PPT按照主流PPT内容结构进行制作,主要由标题页、目录页、关键主题要点、关键内容叙述组成,能够满足;

1.2 文档总结生成PPT AI灵感PPT能够处理非常多文字的文章,上下文文章长度最长可达5w字;由AI快速将文章进行内容提炼,并总结成大纲;自动将文章的核心论点提取出来,并通过形成PPT的总体内容框架;

1.3 支持PPTX、PDF、JPG图像等多种格式导出PPT

二、内置4种AI创作工具

2.1 AI思维导图 输入一句话即可生成思维导图,能够快速帮助你搭建知识框架。无限分支知识探索,自由地探索和扩展思维导图中的内容。自由添加子主题、关联节点、注释等,帮助你更全面地展示和分析问题。

2.2 AI绘图 智能AI绘画生成工具,输入关键词就能自动生成高清图片;内置10+种不同风格的绘画模型,快速生成不同主题画风的高清配图;提供两种配图模式,自由、轻松生成高质量的图片。此外,软件还支持基础模型选择,并且可以对风格、叠加强度等进行调整。

- 联想配图模式 可指定内容章节,AI根据章节的内容自动联想与内容相关的配图画面,并自动生成图片;

- 自由配图模式 你可以自由输入配图的画面或场景描述,AI根据你的描述,批量生成配图;

2.3 AI搜图 无限AI图像搜索工具,它通过自然语言处理技术,自动根据关键词扩散联想画面,可以我们快速、准确地搜索和生成所需的图片。

2.4 AI写作 AI文章创作功能,简单输入关键词,一键生成文章,出稿快人一步;场景化创作,内置10+种文章主题和风格模式,专业实用; 功能支持文采提升,风格改写,缩写,总结,解释和多国语言翻译,为创作提供更多的素材灵感;不同的指令能够将相同内容的文本呈现出不同的风格和表达方式,增加文本的多样性

2.5 AI配音 采用AI智能识别技术,一键将文字转换为语音,10+种情感丰富的主播类型可供选择,同时可对声音语调、语速等参数进行设置!

测试兑换码

mt1n、yu75、lqb4、v7dz 兑换入口

共[[list[68]?.comment_count]]条评论

[[v.content]]

[[v2.content]]

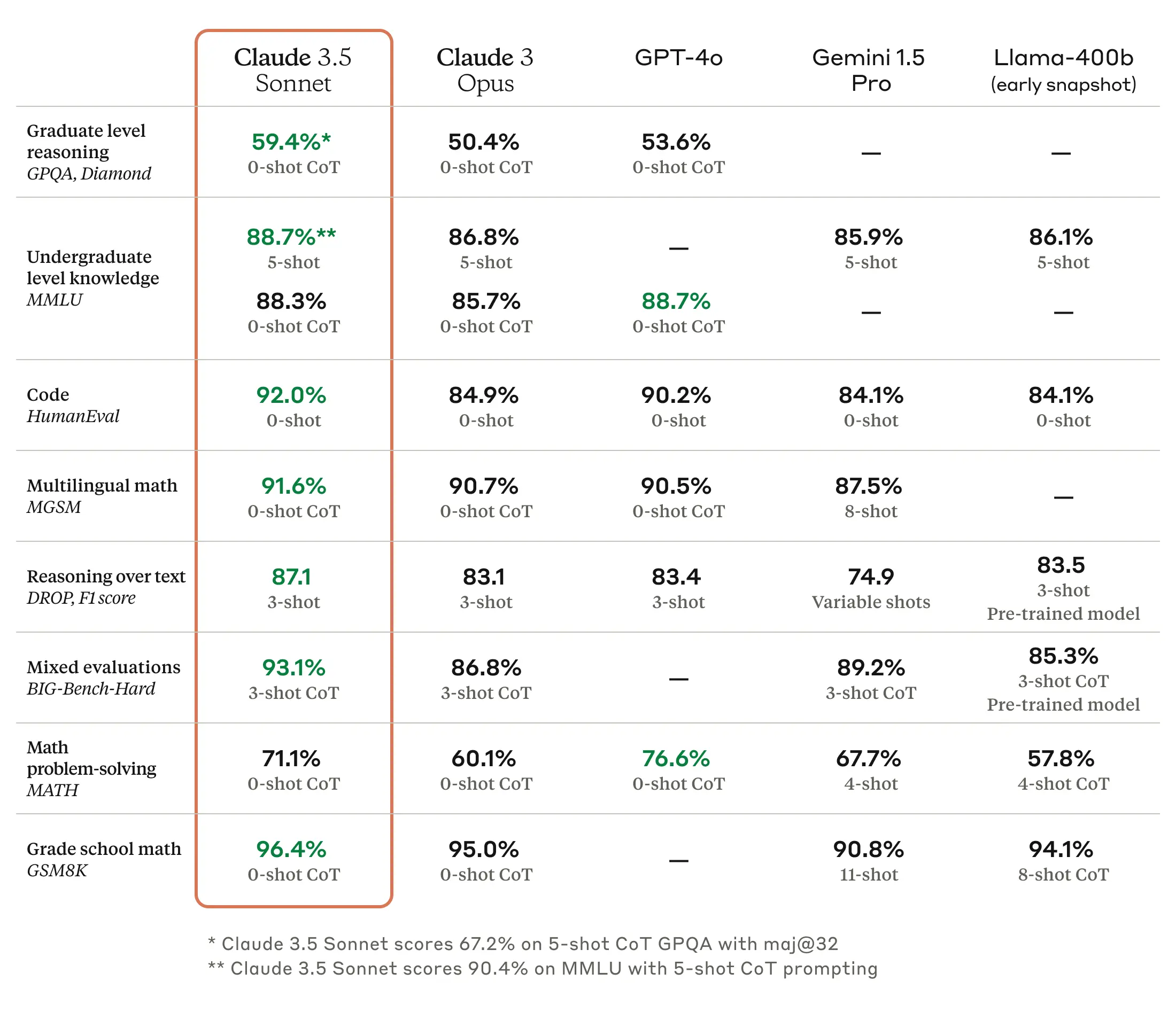

免费Claude 3.5 Sonnet

朋友们!我们整了个[真]免费使用Claude 3.5 Sonnet的站点!!! - Claude 3.5 Sonnet是Anthropic 6月20最新出的目前最强的AI大语言模型 - 据说比gpt4o具有更强的推理能力,实际使用感受确实会更好一点

使用链接

界面简洁

Claude 3.5 Sonnet 性能对比

特点

- 免费Claude 3.5 Sonnet

- 打开即用

- 完全免费

- 无需魔法

- 无需登录

- 服务稳定

- 界面简洁

- 120次/天

共[[list[42]?.comment_count]]条评论

[[v.content]]

[[v2.content]]

AI工具分享

本站目前关于AI的推荐是比较少的,主要是现在的AI工具网站更新得太快了,眼花缭乱,不希望一上来就被AI霸屏 - 写篇汇总分享下我个人目前用得比较多的AI工具 - 我常用的有ChatGPT,llama3,deepseek,通义灵码,dify,uTools中的ChatGPT.好友,Groq

先给大家推荐的是我自己运营的一个GPT免费公益站: https://chatz.free2gpt.xyz

- 完全免费,无需魔法,无需登录,120次/天。目前使用的是Meta最新开源的llama3-70b模型,如果你的任务要求不高,想要一个简洁明了打开即用的AI小工具不妨试试

官方ChatGPT https://chatgpt.com

- 用得最多的一个了,OpenAI还是牛的,可惜国内不能直接访问,需要折腾网络

通义灵码 注册链接(含邀请码) VS Code扩展

- 我感觉他的补全代码挺好用的,会根据打开的文件去找上下文,感觉能有80%的自动补全就是我想要的,能提高不少编程效率,不过对话的话感觉就相对一般,目前个人免费,还是挺香的

deepseek https://platform.deepseek.com

- 很不错的国产开源模型,它的API接口很便宜,百万token1块多,可以作为主API服务集成到AI工具中

uTools(一个很好用的效率工具 https://u.tools)的一款插件 ChatGPT.好友

- 我觉得是最好的AI客户端之一,它可以创建AI好友,不同好友完成不同的任务,每个好友都有丰富的配置,支持添加多个后端服务,AI好友支持绑定线路,配合uTools可以快捷把文本发送到AI好友中处理

dify https://cloud.dify.ai

- dify是一个开源的大语言模型工作流开发平台,提供了大量的外部工具可供AI集成,支持各种AI后端服务,支持生成API接口,使用dify来快速构建AI工作流还是挺方便的

Groq https://console.groq.com

- groq是一家AI推理芯片的创业公司,为了展示他们的推理速度快,他们提供了免费的API接口,可以免费用llama3-70b-8192模型

你常用的AI工具有哪些呢?欢迎评论补充

共[[list[24]?.comment_count]]条评论

[[v.content]]

[[v2.content]]

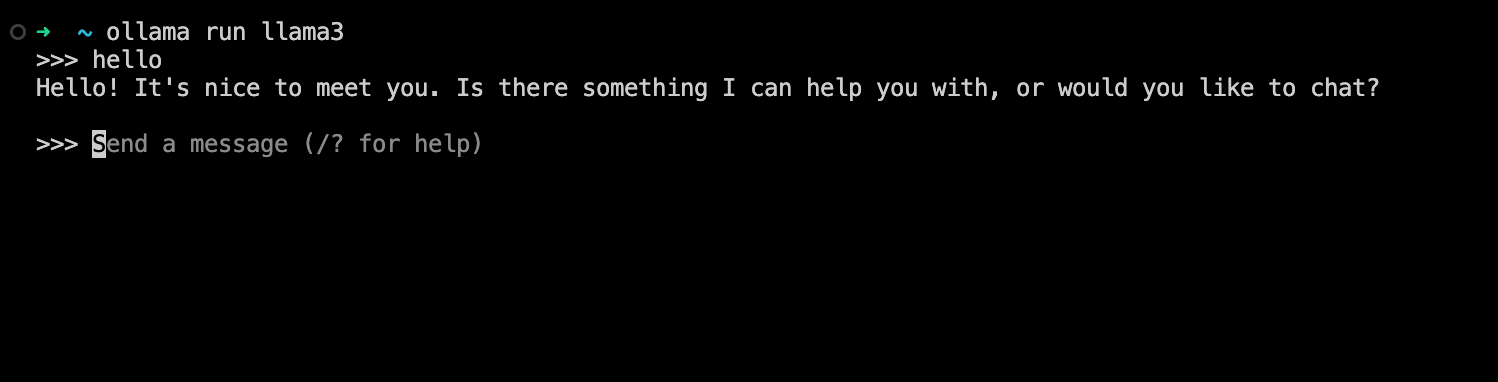

Ollama

ollama是个可以一键运行本地大语言模型的开源平台,可以快速在本地搭建运行开源大语言模型 - 多平台支持 Linux,Windows,MacOS都可以轻松安装 - 一键运行,仅需要一条命令,ollama便可下载运行大语言模型

ollama下载链接: https://ollama.com/download

安装好ollama后仅需要执行 ollama run llama3 即可运行Meta最新发布的llama3模型,直接就可以在命令行中跟本地大模型对话,非常方便

- 首次运行需要下载模型文件llama3默认是8b版本,大小是4.7G

- 运行8b版本大概是需要占用4~5GB内存

- ollama会优先使用显卡,实测1080显卡也能有流畅的输出,没有显卡也会使用CPU来运行,不过速度就很慢

- llama3 70b版本就需要比较高的配置才能运行,推荐64G内存+24G显存

- 支持的模型列表 https://ollama.com/library

- 支持以服务的方式在后台运行:

ollama serve - 支持API方式调用,默认端口是:11434

curl http://localhost:11434/api/chat -d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'- 常用参数,需要以环境变量方式设置

#设置服务监听的主机地址,支持局域网访问

OLLAMA_HOST=0.0.0.0

#同一个模型的最大并发处理数

OLLAMA_NUM_PARALLEL=4

#模型加载数量,设置为2则表示运行2个模型同时运行

OLLAMA_MAX_LOADED_MODELS=2相关链接

共[[list[8]?.comment_count]]条评论

[[v.content]]

[[v2.content]]

共[[list[70]?.comment_count]]条评论

[[v.content]]

[[v2.content]]